Crawler

Ein Crawler ist ein automatisiertes Programm, das Websites systematisch durchsucht und deren Inhalte erfasst, um sie für Suchmaschinen oder andere Analysen auszuwerten.

Auf dieser Seite findest du unsere persönlichen Highlights zum Thema Crawler. Seit über 10 Jahren arbeiten wir als SEO- und Content-Marketing-Berater. In über 300 Podcast-Episoden haben wir zahlreiche Themen besprochen und über 50 ExpertInnen aus Deutschland zu interviewt.

Such dir das Thema aus, das dich persönlich am meisten interessiert 🙂

Der Website-Crawler und SEO

Ein Website-Crawler hilft dir dabei, technische SEO-Probleme zu identifizieren und zu beheben. der eigentliche “Crawl” simuliert den Prozess, den Suchmaschinen wie Google beim Durchforsten einer Website durchführen. Dabei werden alle Seiten und deren Verlinkungen analysiert, um potenzielle technische Hindernisse aufzudecken, die das Ranking beeinträchtigen könnten.

Häufige Probleme, die wir dabei feststellen, sind fehlerhafte Indexierungen, unzureichende Sprachauszeichnungen, langsame Ladezeiten und fehlende Weiterleitungen. Diese Mängel können dazu führen, dass wichtige Seiten nicht korrekt in den Suchergebnissen erscheinen oder gar nicht erst indexiert werden. Unsere Erfahrung zeigt, dass solche technischen SEO-Probleme oft unentdeckt bleiben, da weder im Marketing noch in der IT-Abteilung spezifisches SEO-Fachwissen vorhanden ist. Durch die frühzeitige Durchführung eines Website-Crawls können solche Probleme vermieden und die SEO-Performance nachhaltig verbessert werden.

Kostenloses SEO Online-Training

- Wie du eine SEO-Strategie entwickelst – ohne dich zu verzetteln

- Welche typischen Blockaden es gibt – und wie du sie löst

- Wie andere Marketing-Verantwortliche ihr SEO gemeistert haben

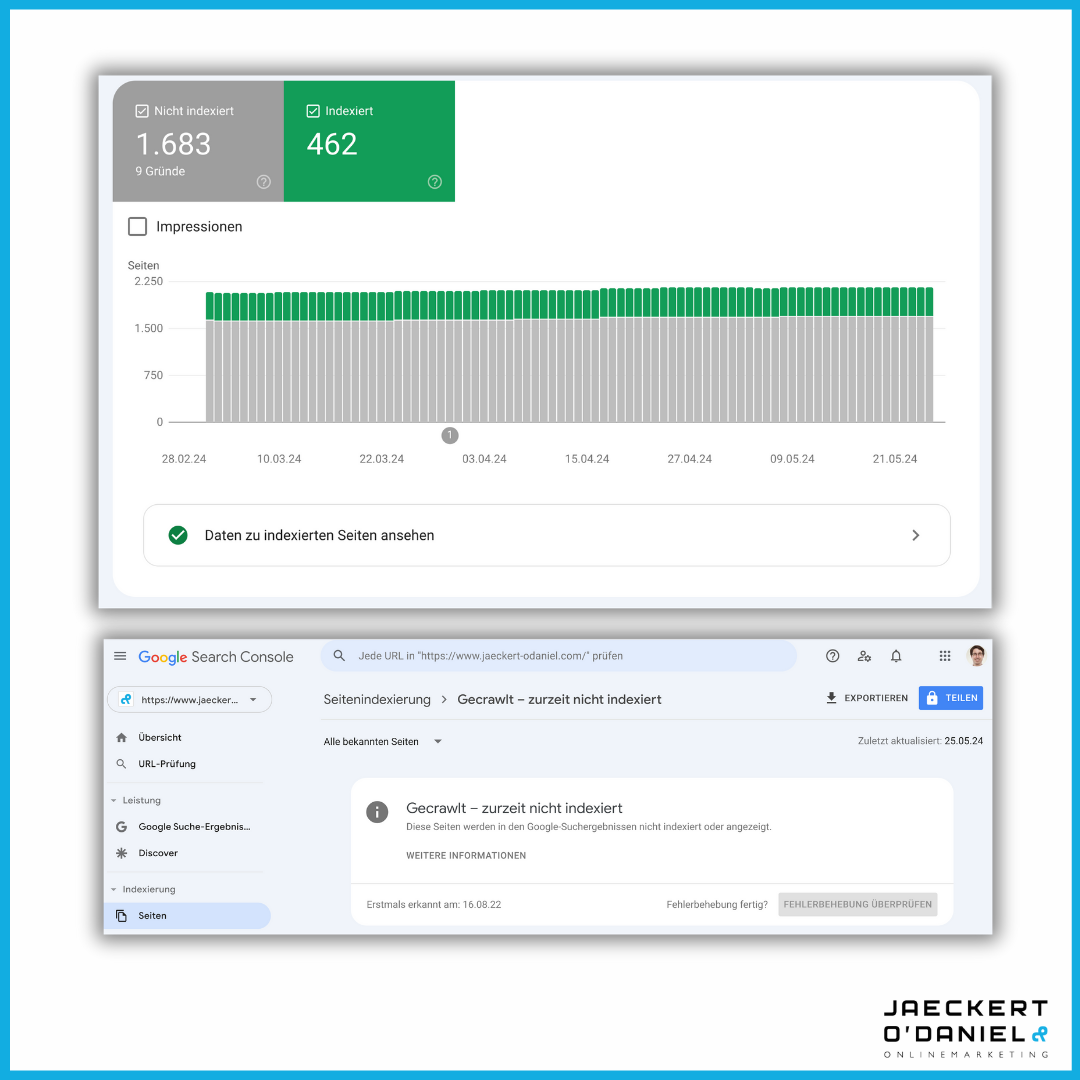

Wenn der Google-Crawler deine wichtigen Seiten ignoriert

Hier thematisieren wir das Problem, dass wichtige Seiten einer Website trotz gezielter Suchanfragen nicht in den Google-Suchergebnissen erscheinen. Dieses Phänomen betrifft z.B. Produktseiten, Glossar-Artikel oder Pressemitteilungen. Die Google Search Console bietet hierfür den Bericht “Gecrawled – zurzeit nicht indexiert” an, der aufzeigt, welche Seiten zwar von Google erfasst, aber nicht indexiert wurden.

Der sogenannte “Graue Index” in der Google Search Console listet alle URLs auf, die Google bekannt sind, aber nicht im Index erscheinen und somit nicht in den Suchergebnissen ranken. Wir empfehlen, den Bericht auf Muster zu untersuchen, um betroffene Seitentypen zu identifizieren und entsprechende technische Probleme zu beheben. Denn eine gezielte Optimierung der Indexierung kann die Sichtbarkeit und den Traffic der Website signifikant steigern.

Interview: Die Kunst des Crawlings

In unserem Interview mit dem erfahrenen SEO-Experten Markus Hövener diskutieren wir die Bedeutung und Methodik des Website-Crawlings für effektive Suchmaschinenoptimierung. Wir erläutern, wie ein systematisches Crawling dabei hilft, die Struktur und Inhalte einer Website zu analysieren, um technische Probleme aufzudecken und die Sichtbarkeit in Suchmaschinen zu verbessern.

Zudem sprechen wir über die Grenzen des Crawlings. Nicht alle SEO-Probleme können allein durch diese Methode identifiziert werden können. Es ist essenziell, die Ergebnisse des Crawlings im Kontext weiterer Analysen zu betrachten und gegebenenfalls zusätzliche Maßnahmen zu ergreifen. Unser Gespräch bietet sowohl Führungskräften als auch Marketing-Managern und SEO-Spezialisten wertvolle Einblicke in die Praxis des Website-Crawlings und dessen Anwendung im täglichen Geschäft.